Las campañas institucionales contra la trata contienen un sesgo abolicionista de la prostitución

Las universidades de Valladolid, Castilla-La Mancha y Católica de Chile analizan una década de mensajes publicitarios en España sobre trata de personas con fines de explotación sexual

La trata de personas es un fenómeno complejo, un comercio de seres humanos que incluye la captación, traslado y explotación de individuos para distintos fines, entre los que está la explotación sexual. En los últimos años, diversas instituciones públicas españolas han desarrollado campañas para visibilizar este asunto y concienciar sobre ello a la población. Según un estudio conjunto de las universidades de Valladolid (UVa), de Castilla-La Mancha (UCM) y Pontificia Católica de Chile, el enfoque mayoritario utilizado en estas campañas presenta algunas carencias, entre las que destaca la falta de contenido informativo sobre la trata con fines de explotación sexual y que se caracterizan por un enfoque abolicionista sobre la prostitución.

Estas campañas de comunicación pública han sido desarrolladas por instituciones como el Ministerio de Sanidad, Servicios Sociales e Igualdad, gobiernos autonómicos y ayuntamientos, sobre todo como consecuencia de la puesta en marcha de planes integrales contra la trata con fines de explotacion sexual. El análisis de sus mensajes institucionales ha sido realizado con el apoyo del Grupo de Investigación en Comunicación Audiovisual e Hipermedia (UVa) y el Grupo de Investigación Semiótica, Comunicación y Cultura (UCM).

“Tenemos dos realidades que conviene diferenciar”, explica María Cruz Alvarado, investigadora en el Departamento de Historia Moderna, Contemporánea y de América, Periodismo y Comunicación Audiovisual y Publicidad de la Universidad de Valladolid. “Por un lado, está la prostitución y por otro la trata de personas con fines de explotación sexual”.

Las investigadoras se han coordinado en una red de investigación interdisciplinar, que ha recibido financiación del Instituto de la Mujer. El foco de interés se puso en saber cómo se está dando visibilidad desde las instituciones públicas españolas a la trata de mujeres y niñas con fines de explotación sexual. Este es un fenómeno al alza como asunto público y comunicativo. En esta línea, la red ha publicado recientemente un trabajo en Comunicar. Revista Científica de Educomunicación en el que aborda la incidencia política de las campañas contra la trata y observa sesgos en su enfoque. La principal conclusión es que a través de las campañas se busca desincentivar la demanda de prostitución más que informar sobre el problema de la trata. Este planeamiento está en línea con el segundo plan integral contra la trata de mujeres y niñas con fines de explotación sexual (2015-2018), actualmente en vigor. “Si bien es una estrategia ya establecida, no parece efectivo para visibilizar el fenómeno de la trata de personas en su complejidad”, resume la especialista de la UVa.

Diez años de campañas

Mujeres sexualizadas, hombres responsables

A través del análisis del discurso se identificaron los ejes ideológicos de los mensajes publicitarios difundidos ya que “el discurso construye una perspectiva acerca de un asunto y de sus protagonistas, y hace una propuesta a los públicos para que se posicionen en torno a la cuestión”. Para ello se analizó la representación que de las mujeres, los demandantes de prostitución, la sociedad y de otros posibles agentes, como los proxenetas o los tratantes, se ha venido haciendo en estas campañas de publicidad institucional.

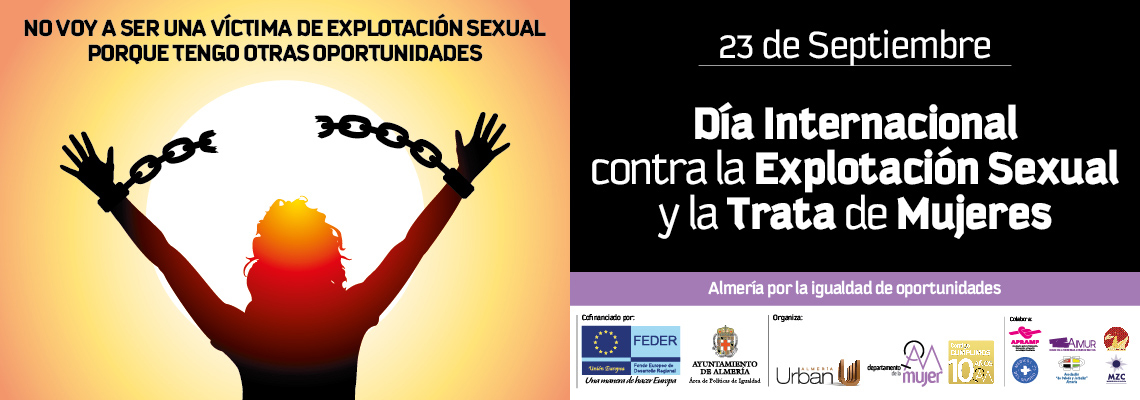

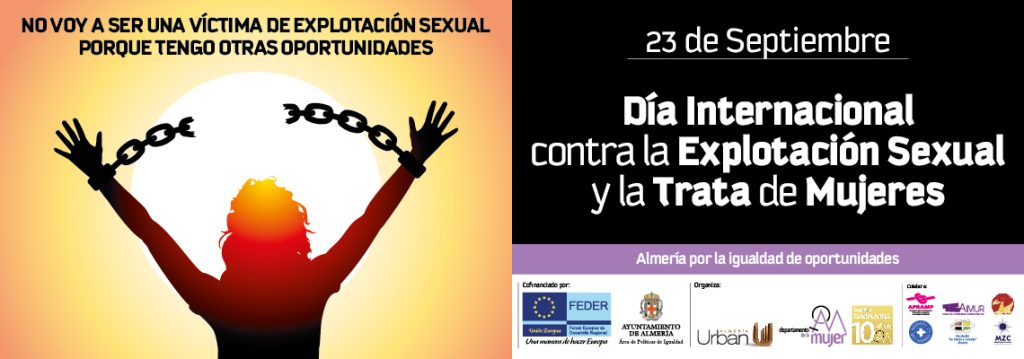

Los resultados indican que a la mujer se la representa mayoritariamente como víctima, lo que incurre, a juicio de Alvarado, en su revictimización: “La condición de víctima puede reproducir y profundizar el estigma, y agudizar el sufrimiento y la vulnerabilidad sufrida por estas mujeres, más aún si en el espacio público a través de estas campañas se la representa como víctima pasiva y desempoderada, cuando deberían servir para ofrecer reconocimiento y facilitar la reparación del daño”. En esta línea de representaciones revictimizadoras, abundan las imágenes de mujeres como mercancías, esclavas y objetos sexuales, Algo que, por ejemplo, ya se ha desterrado de la publicidad más experta contra la violencia machista por los efectos negativos que se sabe tiene esta revictimización. “Antes, las campañas contra la violencia de género empleaban este mismo recurso: una víctima golpeada, incluso con rasgos estéticos bellos,… ahora los mensajes son de empoderamiento de la mujer frente al agresor. Las campañas de trata han incorporado la estrategia de focalización en el agresor, enmarcando en este caso sobre la figura de los demandantes de prostitución, aunque no sobre la figura del proxeneta o explotador”. Sin embargo, en las campañas institucionales contra la trata analizadas solo hay un caso (la del Ayuntamiento de Almería en 2014) en el que se representa a las mujeres no como víctimas sino como agentes con capacidad para salir de la trata y liberarse.

Los hombres, por su parte, aparecen en este tipo de campañas como demandantes de prostitución y “culpables” con su acción de la trata. “Se generaliza este perfil, lo que podría constituir una falacia porque la prostitución no es una actividad ilegal en España”. No en vano, existen colectivos de trabajadoras sexuales que reivindican su derecho al ejercicio libre de esta actividad. Esta asimiliación de la demanda de prostitución como principal causa de la trata y del demandante como su principal responsable es arriesgada, y no debería generalizarse, juzga el equipo investigador en su estudio. Si bien el fenómeno de la prostitución forzada es preocupante, la ONU establece en su informe de 2010 Trata de personas hacia Europa con fines de explotación sexual que la tasa prostitución forzada es aproximadamente un 15%. Son muchos los factores estructurales, de tipo económico, cultural o político en relación a los políticas migratorias, que podrían dar explicación de este fenómeno, más allá del impacto de la demanda, juzga la investigadora de la UVa. Por otro lado, este enfoque invisibiliza y deslegitima la posibilidad de la prostitución como parte de las economías sexuales, prosigue.

Por otro lado, la ciudadanía aparece muy poco representada en estas campañas y si lo hace, figura como un testigo pasivo e impotente, lo que en ningún caso promueve su implicación en la resolución del problema. Y, por último, la presencia de otros actores responsables del delito, como son los tratantes y los proxenetas, es aún más escasa.

El caso de Sevilla

Una de las instituciones que ha destacado en el último decenio (2008-2017) en sus campañas sistemáticas contra la trata de mujeres y niñas con fines de explotación sexual, centradas en acabar con la demanda de prostitución, ha sido el Ayuntamiento de Sevilla. Sin embargo, quizás como evidencia de que el enfoque no es ni efectivo ni eficiente, estas campañas han encontrado recientemente una respuesta crítica en el Colectivo Prostitutas de Sevilla, cada vez más visible y cohesionado. Con motivo del día internacional de las trabajadoras sexuales, este colectivo lanzó su propia campaña reclamando el libre ejercicio de este trabajo sexual, que además cuenta con el apoyo sindical para la reivindicación de sus derechos.

Bibliografía

Vanesa Saiz-Echezarreta, María Cruz Alvarado, Paulina Gómez-Lorenzini. ‘Incidencia política de las campañas contra la trata: un relato controvertido’. Comunicar. Revista Científica de Educomunicación. Vol. XXVI, nº 55, 2º trimestre, 1 abril 2018. E-ISSN: 1988-3293 / ISSN: 1134-3478. DOI: https://doi.org/10.3916/C55-2018-03